ここからコンテンツです。

Humans can empathize with robots

Neurophysiological evidence for human empathy toward robots in perceived pain By Michiteru Kitazaki

Michiteru Kitazaki and his colleagues in cooperation with researchers at Kyoto University have presented the first neurophysiological evidence of humans’ ability to empathize with a robot in perceived pain. Event-related brain potentials in human observers, reflecting empathy with humanoid robots in perceived pain, were similar to those for other humans in pain, except at the beginning of the top-down process of empathy. This difference may be caused by humans' inability to adopt a robot’s perspective.

Empathy is a basic human ability. We often feel empathy toward and console others in distress. Is it possible for us to emphasize with humanoid robots? Since robots are becoming increasingly popular and common in our daily lives, it is necessary to understand our interaction with robots in social situations.

However, it is not clear how the human brain responds to robots in empathic situations.

Now, researchers at the Department of Information Science and Engineering, Toyohashi University of Technology, in collaboration with researchers at the Department of Psychology, Kyoto University have found the first neurophysiological evidence of humans’ ability to empathize with robots in perceived pain and highlighted the difference in human empathy toward other humans and robots.

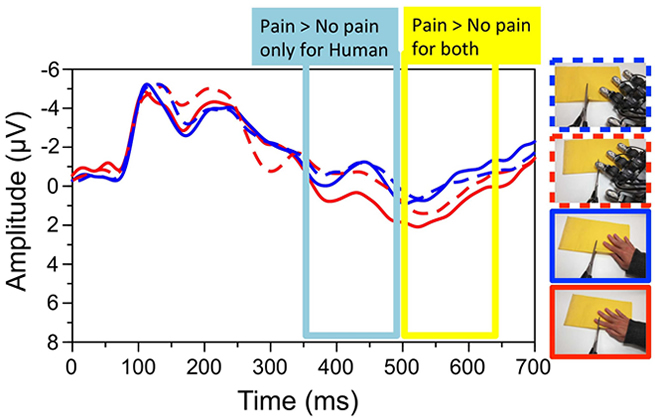

They performed electroencephalography (EEG) in 15 healthy adults who were observing pictures of either a human or robotic hand in painful or non-painful situations, such as a finger being cut by a knife. Event-related brain potentials for empathy toward humanoid robots in perceived pain were similar to those for empathy toward humans in pain. However, the beginning of the top-down process of empathy was weaker in empathy toward robots than toward humans.

"The ascending phase of P3 (350–500 ms after the stimulus presentation) showed a positive shift in the observer for a human in pain in comparison with the no-pain condition, but not for a robot in perceived pain. Subsequently, the difference between empathy toward humans and robots disappeared in the descending phase of P3 (500–650 ms)", explains Associate Professor Michiteru Kitazaki, "The positive shift of P3 is considered as reflecting the top-down process of empathy. Its beginning phase seems related to the process of perspective taking, as was shown in a previous study."

These results suggest that we empathize with humanoid robots in a similar fashion to the way we do with other humans. However, the beginning of the top-down process of empathy is weaker for empathy toward robots than toward humans. This may be a result of human inability to adopt a robot’s perspective.

It is reasonable that we cannot take the perspective of robots because their body and mind (if it exists) are very different from ours. The researchers are experimenting with manipulating humans’ adopting of a robot’s perspective in a follow up study. This study will contribute to the development of human-friendly robots we can feel sympathy for and be more comfortable with.

This study was supported by a Grant-in-Aid for Scientific Research (A) #25245067, #25240020, and #26240043 by JSPS, MEXT, Japan.

Reference

Yutaka Suzuki, Lisa Galli, Ayaka Ikeda, Shoji Itakura and Michiteru Kitazaki (2015). Measuring empathy for human and robot hand pain using electroencephalography. Scientific Reports, 5:15924; doi: 10.1038/srep15924

人はロボットにも共感する

ロボットの痛みに対する共感脳波北崎充晃准教授の研究グループと京都大学の共同研究チームは、痛そうな状況にあるロボットに対して人が共感する証拠を脳波で初めて発見しました。また痛そうな人に対する場合とロボットに対する場合の脳波の違いも明らかにしました。人とロボットの違いは、視点取得(相手の視点に立つ)能力の違いによるもので、人がロボットの立場になることに困難を感じるからだと推察されました。

他者に共感することは人の基本的な能力です。私たちは、苦境にある他者にしばしば共感し、同情を示します。しかし、他者がロボットであるとき、人は共感を示すでしょうか?現在、さまざまなロボットが身近になり、日常生活にも入ってきつつあります。そこで、人がロボットとどのような社会的インタクラションをするかを解明することが望まれています。

しかし、ロボットに対する共感の研究は少なく、特に脳波に関する研究はありませんでした。

豊橋技術科学大学情報・知能工学系の北崎充晃准教授と京都大学文学部心理学研究室の板倉昭二教授らによる共同研究チームは、痛そうな状況にあるロボットに対して人が共感する証拠を脳波で初めて発見しました。また痛そうな人に対する場合とロボットに対する場合の脳波の違いも明らかにしました。

15人の健康な成人を対象として、人あるいはロボットの手にナイフが刺さりそうになっているような痛みあり写真とナイフが離れている痛み無し写真を観察しているときの脳波が計測されました。痛みあり・無しに関係する脳波成分(事象関連電位)は人に対する場合も、ロボットに対する場合も基本的に同じでした。しかし、共感の高次成分と言われるものの前半は、人に対するよりもロボットに対するときに減弱しました。

共感の高次成分P3の前半(写真が提示されてから350-500msの陽性成分)は、人の写真では痛みがある場合により陽性にシフトしました。しかし、ロボットではこの効果は小さいか見られませんでした。その後、この成分P3の後半(500-650ms)では、人でもロボットでも痛みがある場合に陽性にシフトし、人とロボットの差はなくなりました。P3前半は、視点取得(他者の視点に立つ、相手の立場になる)に関係しているのではないかと言われており、人とロボットの共感の違いも、視点取得に関係していると推察されます。

つまり、私たちは人に対してもロボットに対してもほぼ同様に共感しますが、高次の共感の立ち上がりでは、ロボットの視点に立つことに困難を感じることから共感の脳波成分が減弱することが示唆されました。

ロボットは見た目も心も(もしロボットに心があるとしたらですが)私たち人間とは違います。ですから、人がロボットの視点に立つのに困難を感じることは不思議なことではありません。研究者らは、次に、どうしたら人が容易にロボットの視点に立てるか、その場合共感はどうなるのかを調べています。こうした研究は、人に優しく、人が共感し安心できるロボットを開発することに貢献します。

本研究は、文部科学省・日本学術振興会科研費・基盤研究(A)#25245067、#25240020、および#26240043の補助を受けて遂行されました。

Researcher Profile

| Name | Michiteru Kitazaki |

|---|---|

| Affiliation | Department of Computer Science and Engineering |

| Title | Associate Professor |

| Fields of Research | Perceptual Psychology / Cognitive Neuroscience / Virtual Reality |

ここでコンテンツ終わりです。