ここからコンテンツです。

Robot's disfluent speaking just to get attention from you

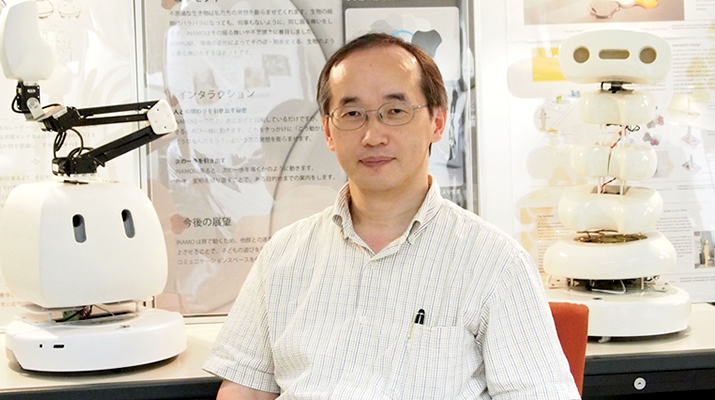

Dynamically adapting robot’s utterance and body language based on subtle human cues By Michio Okada

Michio Okada and his colleagues have developed Talking-Ally, the novel robot that dynamically generate appropriate utterances and gestures based on the person’s attention as indicated by his or her actions. The experiments show that this new communicative approach significantly enhances the attention engagement of interactive users.

Communication between humans is based on one another’s words and body language. We can sense whether the other person is distracted, and we change the course of our conversation and our actions to regain their attention.

Most existing robots, however, still use monologue mechanisms, even when engaging in dialogue with a person. For example, they continue speaking in the same way, even if the person is not paying attention.

Researchers at the Interactions and Communication Design (ICD) Lab at Toyohashi University of Technology have devised a novel robotic communication approach that takes into account the listener’s attention. The robot follows a person’s gaze and determines if that person is distracted by, for instance, a sports event in the background or something in their surroundings. For example, the robot bends forward and nods if the person it is communicating with is watching television, similarly it turns its head and looks around if the person is looking elsewhere. These behaviors are accompanied by an appropriate utterance intended to regain the person’s attention. Experiments have confirmed that these adaptive interactions considerably increase the level of the other party’s attention focused toward the robot as compared with the case where the robot’s gestures and speech are generated without considering the person’s gaze.

“We have set up an environment to manipulate the person’s attention with an engaging sports program broadcast simultaneously with the human-robot interaction. This allowed us to validate a suite of conversation situations and utterance-generation patterns,” said Hitomi Matsushita, first author of the conference paper on the robot.

“Talking-Ally dynamically determines and synchronizes its body language, turn initials, and entrust behaviors of its speech, according to the person’s attention coordinates,” Professor Michio Okada, head of the ICD Lab, explained. “Our analysis shows that this is significantly more persuasive than generating these behaviors randomly.”

The experimental results significantly contribute to the HRI community by confirming that adaptive communication is essential in acquiring and maintaining attention during conversation. Moreover, Talking-Ally demonstrates a specific communication protocol that is shown to successfully re-engage a distracted person. This is instrumental in achieving persuasive communication and convincing interaction with the robot. Such a platform can ultimately be tailored for use with any HRI application.

Talking-Ally currently chooses its responsive gestures at random from a set that suitably corresponds to the person’s level of attention. Future work on the project will include further customizing the robot’s interaction to individuals by choosing a specific body language to use in each situation based on subtle cues from the other party.

This research has been supported by both Grant-in-Aid for scientific research of KIBAN-B (26280102) and Grant-in-Aid for scientific research for HOUGA (24650053) from the Japan Society for the Promotion of Science (JSPS).

References

Hitomi Matsushita, Yohei Kurata, P. Ravindra S. De Silva, and Michio Okada (2015). Talking-Ally: What is the Future of Robot’s Utterance Generation? Proceedings of the 24th IEEE International Symposium on Robot and Human Interactive Communication (RO-MAN 2015), Kobe, Japan. Best Paper Award Finalist.

Naoki Ohshima, Yusuke Ohyama, Yuki Odahara, P. Ravindra S. De Silva, and Michio Okada (2015). Talking-Ally: The Influence of Robot Utterance Generation Mechanism on Hearer Behaviors, International Journal of Social Robotics, 7(1), 51-62.

ロボットからの非流暢な発話が人との親和的な関わりを引き出す

人の微細なしぐさにあわせてダイナミックに発話と身振りを生み出すロボット岡田美智男らの研究グループは、相手の視線やしぐさからその人が何に注意しているかを推定して発話と身振りをダイナミックに制御する新しいロボット(Talking-Ally)を開発しました。いくつの実験の結果,このロボットはユーザーとの親和的な関わりを生み出すことができました。

人間の対話的なコミュニケーションは他者の言葉や身振りに基づいて行われます。我々は相手が自分との会話に集中しているか、聞き手となってくれているかどうかを感じることができ、相手の注意を取り戻すために自らの行動や発話を変えます。

しかしながら、多くのロボットは人と対話する時でさえ、未だにモノローグ・独白的な発話生成のメカニズムを用いています。例えば、人が注意を向けていてもいなくても、ロボットは同じ調子でしゃべり続けます。

豊橋技術科学大学のインタラクションデザイン研究室(ICD-lab)の研究者らは、聞き手の注意を考慮した新しいロボットの発話生成メカニズムを考案しました。Talking-Allyは人の視線を追い、背景にあるスポーツイベントや周りにある何かによって人の注意が逸れているかどうかを判断します。Talking-Allyは人がテレビを見ていたら前かがみになって頷いたり、どこか他の場所を見ていたら頭を回転させたりキョロキョロしたりします。これらのしぐさと「えーと」「あのー」などの発話を組み合わせて,Talking-Allyは人の注意を取り戻そうとします。このような適切なインタラクションは、人の視線や注意を考慮せずに身振りや発話を行う場合に比べて、大幅に人の注意をロボットの方へ向かせることができることが実験で確認されました。

「私たちは人とロボットのインタラクションのさなかに、魅力的なスポーツ番組に人の注意が逸れてしまうようなしかけを作りました。それによって、会話の状況や発話生成パターンの組み合わせの有効性を検証することが可能になりました。」と筆頭著者の松下ひとみさんは述べています。

「Talking-Allyは聞き手の状態にあわせて身振りや話し始めの言葉(発話開始要素)、しぐさをダイナミックに決定し、それらを発話と同期させます」とインタラクションデザイン研究室の岡田美智男教授は説明しています。「これらの振る舞いをランダムに表出するよりも、ずっと説得力のある発話となることを我々の分析は示しています。」

本研究が示した,「適応的な発話調整のメカニズムが会話の中で注意を引き付けたり維持したりするために重要である」という知見は、人とロボットのインタラクション研究の進展に大変役に立ちます。さらに、Talking-Allyは注意が逸れた人を上手く会話に取り戻すためのコミュニケーションプロトコルを明確にしました。これは説得力のあるコミュニケーションを成立させ、ロボットとのインタラクションを確実にする一助となります。そのような研究プラットフォームは、最終的には人とロボットのインタラクションに関するあらゆるアプリケーションにも適用できます。

現在、Talking-Allyは人の注意のレベルに対応するセットから、ランダムに反応の身振りを選択しています。将来は相手からの微細な手がかりに基づいて各状況に応じて適切な身振りを使い分け選択することで、個々に応じたロボットのインタラクションをさらにカスタマイズしていく予定です。

本研究は、文部科学省科研費基盤B(26280102)、挑戦的萌芽研究(24650053)の助成を受けたものです。

Researcher Profile

| Name | Michio Okada |

|---|---|

| Affiliation | Department of Computer Science and Engineering |

| Title | Professor |

| Fields of Research | Cognitive Science / Social Robotics / Interaction |

ここでコンテンツ終わりです。